Es sollte das ultimative Experiment werden, nur deshalb hatte Nathan, der Chef eines Suchmaschinenkonzerns, seinen jungen Angestellten Caleb in seine Villa eingeladen. Nathan stellt Caleb die attraktive Ava vor, einen Roboter, die ihm im sogenannten Turing-Test spielend leicht menschliche Fähigkeiten nachweist. Aber das genügt Nathan nicht. Er möchte herausfinden, ob Caleb sich in Ava verlieben kann, wohl wissend, dass sie eine Maschine ist. Tatsächlich tut er das und hilft ihr sogar zu fliehen. Auf der Flucht aber tötet Ava Nathan und sperrt Coleb in einen Raum, aus dem es kein Entrinnen gibt. Beide hatten ihre kalte Intelligenz unterschätzt.

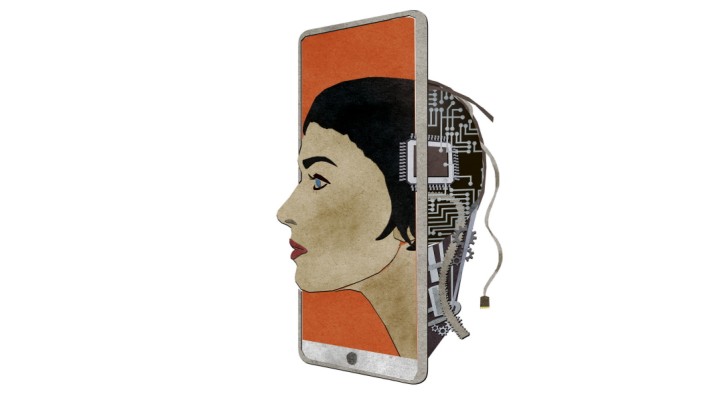

Der 2015 erschienene britische Spielfilm "Ex Machina" bedient ein Science-Fiction-Klischee: Eine künstliche Intelligenz (KI), gefühlskalt und gefährlich, überflügelt und bedroht die Menschen. Forscher rollen allerdings angesichts solcher Visionen die Augen. Selbst der berühmte Turing-Test löst nur noch wenig Begeisterung aus. Die meisten Wissenschaftler finden, dass er an den relevanten Forschungsthemen vorbei testet und der Öffentlichkeit einen falschen Eindruck von der Leistungsfähigkeit heutiger KI-Systeme gebe.

Der Test basiert auf einer Idee des genialen britischen Mathematikers Alan Turing (1912 - 1954), der die Frage aufwarf, wie man feststellen kann, ob eine Maschine denken könne. Er schlug folgendes Spiel vor: Auf einer Party verstecken sich ein Mann und eine Frau und kommunizieren mit den Gästen ausschließlich schriftlich. Beide versuchen, die Gäste davon zu überzeugen, dass sie die jeweils andere Person seien. Was wäre nun, wenn eine dieser Personen durch eine Maschine ersetzt werden würde? Könnte sie die Gäste ebenso gut manipulieren? Aus dieser Idee entwickelten Forscher nach Turings Tod den nach ihm benannten Test. Dabei chatten ausgewählte Jury-Mitglieder einige Minuten mittels Rechner mit einem unbekannten Gegenüber und müssen durch geschicktes Fragen herausfinden, ob sie mit einem Menschen oder einer Software kommunizieren.

Viele Programme zeigen vor allem eines: Menschen lassen sich sehr leicht täuschen

Im Jahr 2014 führten die britische Ingenieurin Huma Shah und ihr Kollege Kevin Warwick an der Royal Society London einen solchen Test durch, und zum ersten Mal gelang es einer Software, ihn zu meistern. Der russische Chatbot Eugene Goostman von Wladimir Weselow konnte in mehreren fünfminütigen Konversationen ein Drittel der Jury-Mitglieder davon überzeugen, ein Mensch zu sein - das reichte, um zu bestehen. Warwick sprach von einem Meilenstein, doch seine Kollegen weltweit protestierten. Eugene gab vor, ein 13-jähriger Junge zu sein, was sein Weltwissen stark einschränkte. "Was Goostmans Sieg wirklich offenbarte, ist die Leichtigkeit, mit der wir andere Menschen täuschen können", schrieb der Kognitionswissenschaftler Gary Marcus von der New York University. Das Programm sei nur deshalb erfolgreich gewesen, weil es mit einfachen Tricks seine Beschränkungen verschleiert hat. Sobald Goostman im Chat überfordert war - was die meiste Zeit der Fall war -, versuchte er, das Thema zu wechseln, Fragen zu stellen oder Witze zu reißen.

Immer mehr Stimmen, darunter Francesca Rossi, KI-Forscherin zuletzt an der italienischen Universität Padua und derzeit bei IBM, fordern daher neue Teststandards. "Der Turing-Test hat unseren Ansatz zur modernen KI-Entwicklung maßgeblich geprägt, weil er erstmals einen Standard schuf, um die Intelligenz des maschinellen Lernens zu messen", sagt Rossi. "Allerdings wurde der Test vor mehr als sechs Jahrzehnten eingeführt. Inzwischen ist er eher ablenkend als förderlich, da er als Benchmark keine praktische und umfassende Messung der KI-Fähigkeiten bietet, wie sie heute existieren."

Auch sei die Frage noch immer nicht beantwortet, was Intelligenz eigentlich ist, sagt Christian Bauckhage vom Fraunhofer-Institut für Intelligente Analyse- und Informationssysteme in Sankt Augustin. "Es ist extrem schwierig, Intelligenz zu beschreiben. Bedeutet es, Sachen zu erkennen, Pläne zu machen, in der Umwelt zu überleben? Ein präzise Definition gibt es nicht, und das war Turing klar." Deshalb sei er bei seiner Spielidee davon ausgegangen, dass Intelligenz im Auge des Betrachters liege.

Als Bauckhage noch an der Universität Bielefeld tätig war, entwickelte er Roboter, die als Assistenten für Menschen eingesetzt werden sollten. Sie konnten Audiosignale verarbeiten, aber oft verstanden sie selbst einfache Sätze nicht, zum Beispiel "Hol mir mal ein Glas". Die Forscher lösten das Problem durch eine simple Ergänzung: Die Roboter sagten: "Entschuldigen Sie, ich bin nur ein Roboter, könnten Sie den Satz wiederholen?" Das fanden die Testnutzer gut. "Das reichte aus, damit sie dachten, der Roboter sei intelligent", so Bauckhage.

Watson konnte Diagnosen stellen, auf die Ärzte nicht kamen

Ähnliches schaffte schon in den 1960ern Eliza, einer der ersten Chatbots, entwickelt von dem Informatiker Joseph Weizenbaum vom MIT. Das schlichte Programm regte Studenten an, ernsthafte Gespräche mit ihm zu führen, dabei täuschte die Software ihre Intelligenz durch unverbindliche Sätze wie "Da bin ich anderer Meinung" vor, oder wiederholte einfach die Eingaben der Nutzer leicht verändert in Frageform. "Auf gewisse Art und Weise war Eliza schon dazu in der Lage, den Turing-Test zu bestehen, denn es dauerte lange, bis Menschen begriffen, was dahintersteckte", sagt Bauckhage. "Wenn wir Menschen uns unterhalten, schreiben wir uns gegenseitig automatisch Intelligenz zu, weil sich der andere so verhält, wie wir es erwarten."

Das Bestehen des Turing-Tests ist somit weder ein Hinweis darauf, wozu KI in der Lage ist, noch darauf, wo ihre Mängel liegen. Erhebliche Leistungen bringt die KI zum Beispiel bei der Extrahierung von Wissen aus großen Datenmengen. Das IBM-System Watson etwa kann medizinische Patientendaten und Studien auswerten und Diagnosen sowie Therapie-Vorschläge erstellen. Auch wenn die Ergebnisse nicht perfekt sind - Watson konnte bereits Krankheiten identifizieren, die Ärzte nicht erkannt hatten. In Tokio diagnostizierte das System zum Beispiel bei einer 60-jährigen kranken Frau eine seltene Leukämie, deren Symptome die Ärzte vor ein Rätsel gestellt hatten. Watson ist ein mächtiges Tool, was aber nicht heißt, dass Watson schlauer ist als ein Mensch.

Es gibt eben eine ganze Reihe von Fragen, mit denen KI-Programme überhaupt nicht zurechtkommen, während sie für Menschen leicht zu beantworten sind. Ein Beispiel ist die Vermischung von unbestimmten Zeitsequenzen und Sachwissen: Maria besitzt einen Kanarienvogel namens Paul. Hat Paul Vorfahren, die 1750 am Leben waren? Bisher wurde kein System implementiert, das solche Fragen beantworten konnte. Ein weiteres Beispiel: Angenommen, jemand besitzt zwei identische Bücher, eines mit weißem Cover, eines mit schwarzem. Würde man aus dem weißen eine Seite herausreißen, würde die Seite auch aus dem schwarzen Buch fallen? Würde eine Seite in das schwarze Buch hineinwachsen? Oder nichts von all dem? Weil die Fragen so absurd sind, hat die KI keine Datenbasis, aus dem sie eine Antwort beziehen könnte. Sie ist auf Informationen angewiesen, die sie in Datenbanken oder dem Internet findet.

Auch die Sprachverarbeitung bereitet der KI noch große Schwierigkeiten. Das zeigen zum Beispiel Diktierprogramme. "Aufgabe ist es, das Gesprochene fehlerfrei in Zeichen und Wörter zu überführen, aber bei der tatsächlichen Verwendung muss das Programm zwischen Diktier- und Meta-Eingaben unterscheiden, also Kommandos verstehen wie 'neue Zeile' oder 'schreib die letzten drei Wörter kursiv'", erläutert Reinhard Karger, Computerlinguist und Sprecher des Deutsches Forschungszentrums für Künstliche Intelligenz (DFKI) in Saarbrücken. Dies gelingt heute noch nicht intuitiv. Es funktioniert nur, wenn vorher spezielle Befehle gelernt wurden. Auch können solche Systeme keine Satzzeichen automatisch ergänzen. Zudem, so Karger, würde jedes System heute beim Turing-Test in gesprochener Sprache versagen. Es fehle an einer adäquaten Satzmelodie mit Variationen in Lautstärke, Betonung und Fokus. Da gäbe es noch viel zu tun.

der Fragen in einem Leseverständnistest der University of Stanford konnte Anfang dieses Jahres ein KI-System des chinesischen IT-Konzerns Alibaba beantworten. Einen Tag später erreichte eine Microsoft-KI sogar 82,65 Punkte. Sie waren damit beide besser als alle menschlichen Probanden bislang, unter ihnen erreicht der beste Teilnehmer nur 82,30 Prozent. Das sogenannte Stanford Question Answering Dataset enthält 100 000 Fragen und Antworten, die auf Wikipedia-Artikeln beruhen.

Es ist folglich nicht leicht, Testverfahren zu entwickeln, die solche Mängel aufdecken. Ein bereits existierender Test, der dies ansatzweise versucht, ist die sogenannte Winograd Schema Challenge, entwickelt an der Universität Toronto. Dort wird sozusagen der gesunde Menschenverstand des Rechners geprüft. Forscher geben den KI-Systemen Sätze vor, die mindestens ein Pronomen mit mehreren Bezügen aufweisen. Die KI muss herausfinden, welcher davon sinnvoll ist.

Ein typisches Beispiel geht so: Ein Kunde betritt eine Bank und sticht auf den Kassierer ein. Er wird in die Notaufnahme gebracht. Wer wird in die Notaufnahme gebracht? Menschen wissen, wer gemeint ist, aber für Rechner ist es schwierig. Dafür brauchen sie ein breites Basiswissen. Sie müssen begreifen, dass Stiche mit Verletzungen verbunden ist und dass eine Notaufnahme verletzte Menschen behandelt. Das Problem bei dem Winograd-Test ist, dass solche Fragen konstruiert sind und somit nur mit großem Aufwand auf umfassende Themengebiete skaliert werden können.

Das System Aristo schafft 75 Prozent der Schulaufgaben von Viertklässlern

Forscher um Peter Clark vom Allen Institute for Artificial Intelligence in Washington schlagen daher vor, einfach die Schulklausuren von Sechs- bis 18-Jährigen als Benchmark für eine KI zu nehmen, und zwar ohne die Aufgaben umzuformulieren. Dabei handele es sich um Fragestellungen aus dem Alltag, die größtenteils nicht mittels Suchmaschinen-Abfragen oder statistischer Sprachanalyse beantwortet werden können. Sie setzen ein gewisses Weltverständnis voraus. Eine Beispielaufgabe für Grundschüler wäre: Ein Mädchen pflanzt zwei identische Pflanzen in die gleiche Art und Menge Erde. Es gibt ihnen die gleiche Menge Wasser, aber legt eine der Pflanzen in die Nähe eines sonnigen Fensters und die andere in einen dunklen Raum. Die Frage wäre: Testet die Schülerin, ob die Pflanzen auf Licht, Luft oder Wasser reagieren?

Der Rechner muss das Versuchsmodell verstehen, das darin besteht, zwei Aufgaben auszuführen, die sich nur in einer Bedingung unterscheiden. Er muss begreifen, dass die Pflanze in der Nähe eines sonnigen Fensters dem Licht ausgesetzt ist und ein dunkler Raum kein Licht aufweist. Clark und seien Kollegen testeten ihr eigenes KI-System Aristo mit solchen Klausur-Fragen. Es schaffte drei Viertel der Aufgaben von Viertklässlern, aber nur 41 Prozent für Klasse zwölf.

Gary Marcus ist selbst dieser Test nicht umfassend genug, daher schlägt er einen Turing-Test vor, für den die Fragen mittels eines Crowdsourcing-Spiels erstellt werden. Dabei erhalten anonyme Teilnehmer aus dem Internet eine Fülle von Dokumenten zu einem bestimmten Thema: Texte, Bilder, Videos, Podcasts. Sie müssen in einem Ratespiel immer detailliertere Fragen und Antworten zum Thema entwerfen, um es aus immer neuen Perspektiven zu beleuchten. Die Fragen sollen anschließend der KI vorgelegt werden.

Der Forscher Charles Ortiz vom kalifornischen Nuance Laboratory for AI and NLP schlägt wiederum vor, dem unbekannten Gegenüber keine Fragen zu stellen, sondern Anweisungen zu geben, zum Beispiel aus Lego einen Tisch zu bauen - mittels ferngesteuerten Roboterhänden. So soll der beim Turing-Test vernachlässigte Zusammenhang zwischen Körperlichkeit und Intelligenz getestet werden.

Letzten Endes wird es auf eine Vielzahl von Tests hinauslaufen. "Ein einzelner Test kann die wachsende Anzahl von Methoden, Techniken und Ansätzen moderner KI-Systeme nicht genau bewerten", sagt Francesca Rossi. Die Bedeutung der Tests dürfe zudem nicht länger darin bestehen, die Intelligenz eines Technologiesystem mit der des Menschen zu vergleichen. Die Tests sollen vielmehr helfen, Lücken im System zu erkennen.

Ein Kritikpunkt am Turing-Test war freilich auch, dass die Aufregung um Bestehen und Nicht-Bestehen solcher Tests von wichtigen gesellschaftlichen Fragen um die KI ablenke. "Es gibt immer mehr KI-Systeme, die für uns im Alltag Entscheidungen treffen, etwa darüber, welche Informationen wir aufnehmen, welche Waren wir konsumieren, bis hin zur Partnerwahl", sagt Thomas Hofmann, Professor für Datenanalytik an der ETH Zürich. "Wir begeben uns in Abhängigkeiten solcher Systeme, ohne zu wissen, wie sie funktionieren, wer sie sich zunutze macht und welche Interessen er damit verfolgt. Das sind viel drängendere Fragen als die, ob eine KI in unserem Sinne intelligent ist."