Nein, Deutschland bekomme keinen "Robocop", so formulierte es die Deutschland-Chefin von Microsoft, Sabine Bendiek, am Montag bei einer Pressekonferenz in Düsseldorf. Aber die Polizei rüstet auf: "Ein Algorithmus, der emotions- und ermüdungsfrei und sehr, sehr schnell arbeitet." Emotion und Ermüdung können in der Ermittlungsarbeit ein Problem sein, wenn es um Kinderpornografie einerseits und gewaltige Datenmengen andererseits geht. Die traurige Realität im Jahr 2019 ist, dass das eine fast immer das andere zur Folge hat.

Allein im Missbrauchsfall auf dem Campingplatz in Lügde beschlagnahmte die Polizei 14 Terabyte Beweismittel - jährlich sind es in Kinderpornografie-Fällen ungefähr 2000 Terabyte. Ein einzelner Ermittler braucht aber im Durchschnitt neun Monate für die Sichtung eines einzigen Terabytes. Ende März waren allein in Nordrhein-Westfalen insgesamt 1895 Ermittlungsverfahren wegen Kinderpornografie anhängig - aber nur in 228 Verfahren konnten bisher die Bilder und Videos ausgewertet werden. Diese Zahlen zeigen: Die deutsche Justiz ist digital nicht gut aufgestellt. Und die schleppende Aufklärung verlängert das Leid der Opfer.

Nordrhein-Westfalen holt sich nun als erstes Bundesland Hilfe. Zusammen mit Microsoft Deutschland, Wissenschaftlern der Universität des Saarlandes, der LYTiQ GmbH und dem Deutschen EDV Gerichtstag sowie der bei der Staatsanwaltschaft Köln angesiedelten Zentralstelle Cybercrime NRW wurde am Montag ein Forschungsprojekt gestartet. Mit dem bundesweit einzigartigen Forschungsprojekt soll kinderpornografisches Bildmaterial deutlich schneller erkannt und ausgewertet werden. Es geht um maschinelles Lernen: Software soll sich selbst beibringen, möglicherweise illegales Material zu erkennen. So sollen die Ermittler so schnell wie möglich ein Assistenzsystem an ihrer Seite haben, das sehr schnell sehr große Datenmengen voranalysieren kann.

Harmloses wie Urlaubsfotos aus den beschlagnahmten Datenbergen taucht bei den Ermittlern dann gar nicht mehr auf. Künftig sollen nur noch die Bilder gezeigt werden, auf denen das System eindeutig Kinderpornografie erkannt hat. Die Bewertung, ob etwas strafrechtlich relevant ist, nimmt dann ein Mensch vor.

Getestet wurde die Technik drei Monate lang an Hunde- und Katzenbildern. Weil der Umgang mit kinderpornografischem Datenmaterial strengen Einschränkungen unterliegt, entwickelte die Forschungsgruppe daher eine spezielle, zweiteilige Cloud-Infrastruktur: Die heiklen Daten werden ausschließlich auf Rechnern der Justiz verarbeitet und dabei so weit zerlegt, dass sie eine auf die Erkennung kinderpornografischen Materials spezialisierte künstliche Intelligenz in der Cloud weiter trainieren, aber nicht wiederhergestellt werden können. Sollte der Algorithmus funktionieren, könnte er im kommenden Jahr bei Polizei und Staatsanwaltschaft zum Einsatz kommen, sagte Nordrhein-Westfalens Justizminister Peter Biesenbach (CDU).

Software erkennt Nacktfotos

Moderne Software kann auch Zusammenhänge zwischen mehreren Bildern erkennen, etwa mehrere Fotos, die in einer Serie am selben Ort aufgenommen wurden. Sie kann auch dasselbe Bild in verschiedenen Formaten finden, etwa einmal auf einem PC gespeichert und einmal, wenn es über Whatsapp verschickt und automatisch entsprechend angepasst wurde. Die Filter anderer Systeme sind auf menschliche Haut eingestellt - zeigt ein Bild viel Nacktheit, schlagen sie Alarm. Auch Software zur Gesichtserkennung wird eingesetzt: Ermittler laden ein Foto eines Kindes oder Täters in das Programm, und dieses durchsucht dann alle Bilder nach weiteren Treffern.

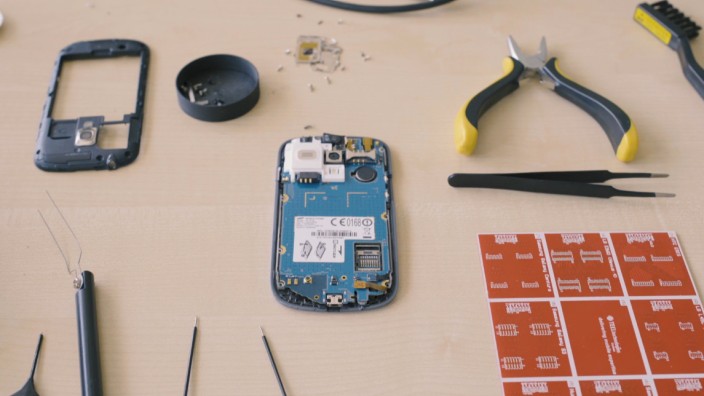

Die von Microsoft entwickelte Technik PhotoDNA ist dabei in einer Art Vorreiterrolle: Sie ist einer der größten Upload-Filter des Netzes. PhotoDNA basiert auf einer Datenbank, in die neu gefundenes Material, das Kindesmissbrauch zeigt, eingepflegt wird. Versucht jemand, dasselbe Bild oder Video erneut auf einer Plattform hochzuladen, die PhotoDNA einsetzt, schlägt das System an. Die Datei wird blockiert. Die großen Anbieter wie Google (in seinem Mail-Dienst) und Facebook setzen PhotoDNA ein. Whatsapp scannt mit PhotoDNA die Profilbilder seiner Nutzer und Chat-Gruppen. Monatlich werden dabei oft mehr als hunderttausend Konten gesperrt. Wegen seiner starken Verschlüsselung kommt der Dienst allerdings nicht an den Inhalt der Chats selbst heran. An die kommt nur, wer Zugriff auf die Geräte hat. Wenn die Polizei sich die bei Razzien geholt hat, kann die neue selbstlernende Software loslegen.