Schon der erste Satz führt in die Irre. "Die Künstliche Intelligenz entwickelt sich schnell" (pdf), heißt es in einem Mitte Februar veröffentlichten Weißbuch, in dem die EU-Kommission Strategien zur Förderung und gleichzeitigen Regulierung der Technologie vorgelegt hat. Neben den üblichen fabelhaften Versprechungen von besserer Medizin, effizienterer Landwirtschaft und natürlich auch der Lösung der Klimakrise, wird die zitierte Kernaussage nicht weiter infrage gestellt oder relativiert.

Ganz so einfach ist es jedoch nicht, denn auf dem Gebiet der künstlichen Intelligenz werden momentan hauptsächlich deshalb so viele Fortschritte erzielt, weil immer größere Rechnerkapazitäten auf die zu lösenden Probleme angesetzt werden. Brute-Forcing nennt man das im IT-Fachjargon. Das Problem daran ist, dass diese Methode schrecklich ineffizient und unelegant ist. Ein Beweis dafür: Ein einzelnes KI-Modell neu auf ein neues Problem anzusetzen, sorgt inzwischen für den ungefähr gleichen CO₂-Ausstoß wie der Betrieb von fünf Pkw.

Unsouveräne Software

Ganz anders als das EU-Papier klingt der KI-Experte Gary Marcus in einem aktuellen Paper (pdf), in dem er die Entwicklungen von künstlicher Intelligenz innerhalb der nächsten Jahre skizziert. "Deep Learning Technologien haben sich bisher als datenhungrig, seicht und spröde erwiesen und sind limitiert in ihrer Fähigkeit zu generalisieren", schreibt er dort. Das bedeutet: Auf Situationen, für die sie nicht trainiert wurde, reagiert KI-Software, nun ja, eher unsouverän: Als Mitarbeiter des IT-Sicherheitskonzerns McAfee ein etwa vier Zentimeter langes Stück schwarzes Klebeband auf einem Verkehrsschild anbrachten, reagierte der vermeintlich intelligente Autopilot eines Tesla, indem er 50 Meilen pro Stunde beschleunigte.

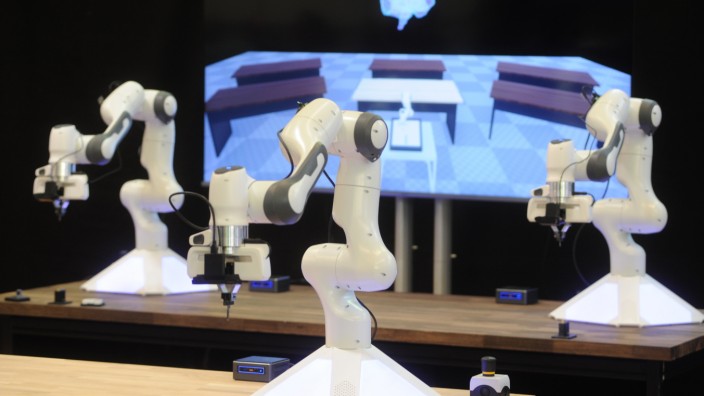

Auch andere Methoden, die in der breiten Öffentlichkeit entweder zu Begeisterung oder zu Angst vor dem Aufstand der Maschinen führen, kämpfen mit Problemen. Reinforcement Learning, also bestärkendes Lernen, ist beispielsweise nichts weiter als Trial and Error auf Steroiden. Nach diesem Konzept funktioniert etwa die von der Alphabet-Tochter Deep Mind entwickelte Go-Software, die seit einigen Jahren sämtliche menschliche Profis das Fürchten lehrt. Das besagt allerdings noch lange nicht, dass die gleiche Software ein anderes Spiel spielen könnte, ja überhaupt versteht, was ein Spiel eigentlich ist. Die Programme müssen jedes Mal alles aufs Neue lernen.

Hier wie dort besteht das Problem darin, dass heutige KIs zwar enorm gut darin sind, Korrelationen zu erkennen, aber keine Ahnung von Ursache und Wirkung haben. Es gilt also, kausale Beweise in mathematische Formeln zu übersetzen. Genau daran arbeitet seit einiger Zeit eine neue Arbeitsgruppe an der New Yorker Columbia University. Das sollte lieber schnell gehen. Denn schon fürchtet man sich in eingeweihten Kreisen vor einem neuen "KI-Winter", also einer Phase, in der die Begeisterung für die Technologie reichlich abkühlt. Das war schon mal der Fall. Noch bis vor wenigen Jahren gab es für angehende Computerwissenschaftler keinen sichereren Weg, ihrer Karriere einen mutwilligen Todesstoß zu versetzen, als auf dem Feld der künstlichen Intelligenz zu forschen.