Yann LeCun galt als eifriger Twitter-Nutzer. Der renommierte KI-Forscher setzte mehrmals täglich seine Tweets ab. Auch an einem Sonntag Ende Juni schrieb LeCun dort über Forschungsergebnisse, riss einen Witz und kommentierte einen Tweet, der Diskriminierung durch Algorithmen thematisiert hatte. Zu diesem Zeitpunkt ahnte er nicht, dass dies einer seiner letzten Tweets sein sollte. Yann LeCun, KI-Chef von Facebook und Gewinner des berühmten Turing Awards, hat Twitter verlassen. Sein Tweet sorgte für einen heftigen Streit um rassistische Diskriminierung durch maschinelles Lernen, einem Teilgebiet der künstlichen Intelligenz. Es ging um die Frage, woran es liegt, dass künstliche Intelligenz manchmal zu rassistischer Intelligenz wird.

Um die Tragweite von LeCuns Rückzug aus Twitter zu verstehen, muss man zwei Dinge wissen. Erstens ist Twitter für viele Informatiker, besonders für junge KI-Forscher, nicht irgendein soziales Medium, sondern ein zentraler Ort des fachlichen Austauschs. Wer Twitter den Rücken kehrt, kehrt einem Großteil der KI-Community den Rücken. Zweitens ist Yann LeCun nicht irgendein KI-Forscher; er hat in den 1990er-Jahren die Convolutional Neural Networks (CNNs) erdacht, die sein Fachgebiet gewaltig umkrempelten. Wenn heute von der Übermacht künstlicher Intelligenz die Rede ist, wenn Chinas Regierung jeden Bürger auf der Straße erkennt und man beim Fast-Food-Restaurant mit dem eigenen Gesicht bezahlen kann, dann liegt das an LeCuns damaligem Durchbruch; Bild- und Teile der Spracherkennung in ihrer heutigen Form wären ohne LeCuns Arbeit undenkbar. Dafür wurde LeCun unter anderem mit dem Turing Award geehrt, der höchsten Auszeichnung in der Informatik.

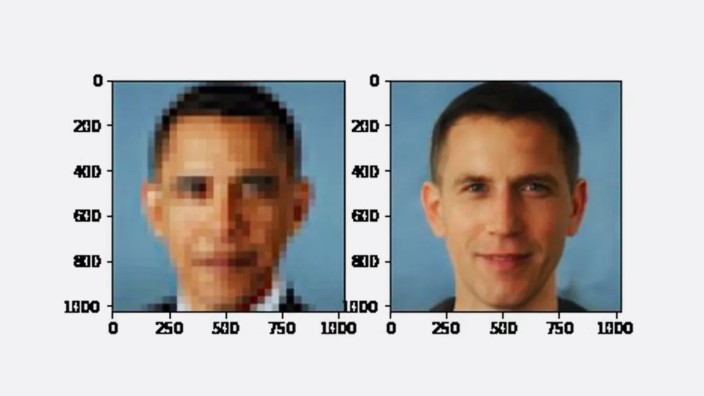

LeCun hatte auf zwei Bilder reagiert: Links ist ein beinahe bis zur Unkenntlichkeit verpixeltes Bild des ehemaligen US-Präsidenten Barack Obama zu sehen, rechts ein hochaufgelöstes Bild einer weißen Person, die ein bisschen wie Obama aussieht. Die Person auf dem rechten Bild ist nicht real, ein neuronales Netz hat das Bild erzeugt. Ziel der Software war es, Obamas Pixel-Bild eine höhere Auflösung zu verpassen. Solche Upsampling-Algorithmen sind derzeit schwer angesagt; sie können unscharfe Bilder aufpolieren, bis diese gestochen scharf sind. Nur: Sie verändern so wichtige Dinge wie die Hautfarbe. Es sind beileibe nicht die einzigen Modelle im maschinellen Lernen, die Menschen diskriminieren. Immer wieder hört man von Algorithmen, die Menschen afrikanischer oder asiatischer Abstammung nicht erkennen, übersehen oder als kriminell einschätzen.

Der Algorithmus lernte von 50 000 Beispielbildern, die meist weiße Menschen zeigten

Wie im maschinellen Lernen üblich, wurde auch der Upsampling-Algorithmus mit Daten aus der realen Welt trainiert, in diesem Fall mehr als 50 000 Porträtfotos. Das Modell sieht - stark vereinfacht gesprochen - jedes dieser Bilder mal gestochen scharf, mal stark verpixelt und lernt daraus, wie es von unscharfen Bildern auf das Aussehen der abgebildeten Menschen schließen kann. LeCun schrieb dazu: "Systeme des maschinellen Lernens sind verzerrt, wenn die Daten verzerrt sind." Er wies darauf hin, dass der Algorithmus vornehmlich mit Bildern hellhäutiger Menschen trainiert wurde - und deshalb hinter Obamas verpixeltem Bild einen "weißen Obama" vermutete. "Man trainiere exakt dasselbe System auf einem Datensatz aus dem Senegal, und jeder wird afrikanisch aussehen."

Daraufhin brach ein Sturm der Entrüstung los. "Man kann solche Fehler nicht einfach nur auf verzerrte Daten zurückführen", schrieb Timnit Gebru, Expertin für ethische Fragen im Bereich künstlicher Intelligenz. Sie richtete sich direkt an LeCun: "Hör einmal auf uns Menschen aus marginalisierten Bevölkerungsgruppen. Wenn nicht jetzt, während der weltweiten Proteste, wann dann?" Gebru bezog sich auf die Demonstrationen nach dem Tod des Amerikaners George Floyd.

LeCun reagierte mit einer ausführlichen Erklärung in 17 Tweets. Er betonte, dass es ihm lediglich um diesen einen Algorithmus ging. Keinesfalls seien immer nur die Daten schuld, wenn KI rassistische Entscheidungen treffe; die gesamte "Architektur eines Modells" könne Vorurteile enthalten. Damit meint LeCun, dass Menschen die Programme schreiben, die mithilfe von Daten lernen. Ihre Vorurteile geben sie dabei nicht selten an die Algorithmen weiter. Im Falle des "weißen Obamas" seien nun mal aber die Profilbilder, also die Trainingsdaten, schuld gewesen. Gebru widersprach auf Twitter nicht. Ihr ging es wohl darum, dass diese Sicht nicht falsch, aber verkürzt ist. In ihren Veröffentlichungen und Seminaren weist Gebru immer wieder darauf hin: Auch Daten wie die Profilbilder fallen nicht vom Himmel; sie sind Ausdruck gesellschaftlicher Werte und politischer Machtverhältnisse.

"Hinzu kommt, dass die Architektur eines Modells Verzerrungen in den Daten noch verstärken kann", sagt Isabel Valera, Professorin für maschinelles Lernen an der Universität des Saarlands. Valera erforscht, wie Algorithmen gerechte Entscheidungen treffen können. Dazu übersetzt sie menschliche Vorstellungen von Fairness in mathematische Formeln und letztlich in Computercode - keine leichte Aufgabe: "Es ist möglich, ein einzelnes Konzept von Fairness zu erfüllen." Unmöglich sei es jedoch, sämtliche Normen zu berücksichtigen.

Computermodelle funktionieren im Grunde wie Wanderkarten. Sie vereinfachen die Realität

Das liegt daran, dass Computermodelle im Grunde wie Wanderkarten funktionieren: Sie vereinfachen die Realität, pressen mehrere Quadratkilometer auf eine Holztafel. Dabei findet nicht jeder Trampelpfad seinen Weg auf die Karte, Information geht verloren. Ein Modell, das alle Menschen und Bedürfnisse berücksichtigt, wäre am Ende so hilfreich wie eine Wanderkarte im Maßstab 1:1. Algorithmen werden also unfair bleiben, KI-Forscher können aber diese Schwächen deutlich stärker wahrnehmen und darauf hinweisen. Erst neulich schrieben über 2000 Wissenschaftler einen offenen Brief an einen Verlag mit der Bitte, eine Publikation über eine Software, die angeblich Straftaten vorhersagt, nicht zu veröffentlichen. Sie befürchteten ein rassistisches Ungleichgewicht im Code. Zu den Unterzeichnern gehörte Yann LeCun.